En el actual entorno empresarial, las organizaciones están segmentando sus operaciones de inteligencia artificial en equipos especializados para optimizar el desarrollo y la implementación de modelos. Por un lado, existe el equipo de investigación de IA, encargado de desarrollar y mejorar los modelos mediante técnicas de entrenamiento y ajuste fino. Por otro, el equipo de hospedaje se ocupa de desplegar estos modelos en distintos entornos de desarrollo, validación y producción.

Una de las herramientas que facilita este proceso es Amazon Bedrock Custom Model Import, que permite al equipo de hospedaje importar y servir modelos personalizados basados en arquitecturas soportadas como Meta Llama 2 y Mistral a través de un sistema de precios On-Demand. Gracias a esta funcionalidad, los equipos pueden importar modelos con pesos en el formato de Hugging Face safetensors desde Amazon SageMaker o Amazon S3, lo que facilita el trabajo conjunto con los modelos de base existentes de Amazon Bedrock.

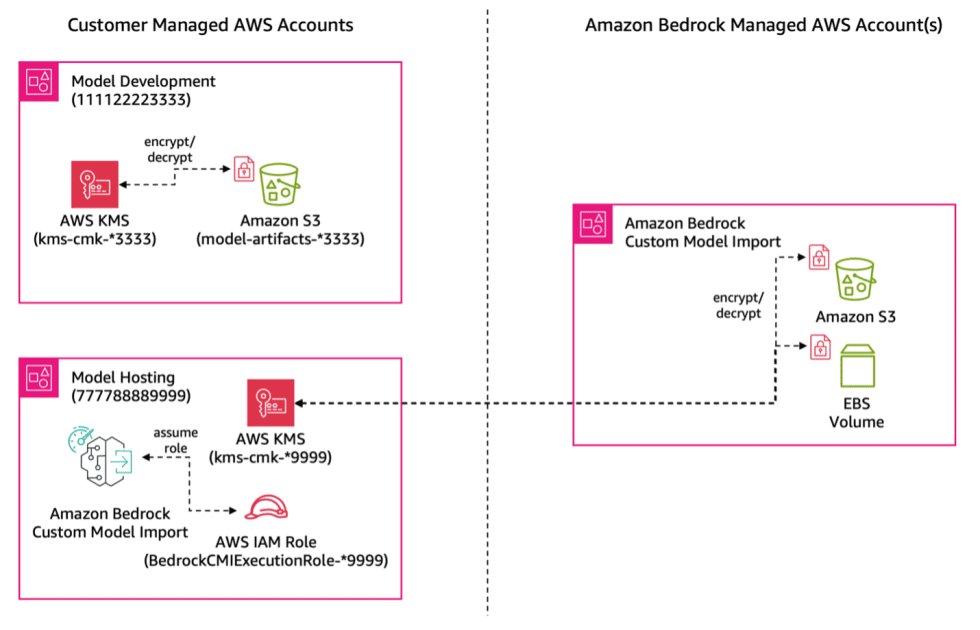

Sin embargo, un reto significativo surge en estos entornos: el acceso a los artefactos de modelo alojados en cuentas de AWS separadas. Normalmente, los resultados de entrenamiento, como los pesos del modelo, son almacenados en S3 dentro de la cuenta del equipo de investigación, y el equipo de hospedaje necesita acceder a dichos artefactos para llevar a cabo el despliegue. Es aquí donde entra en juego el soporte para acceso entre cuentas en Amazon Bedrock Custom Model Import, que permite configurar accesos directos entre los buckets de S3 y las cuentas de hospedaje, optimizando el flujo operativo sin comprometer la seguridad.

Un ejemplo de esta colaboración se da en Salesforce, donde el equipo de plataforma de IA ha destacado cómo esta funcionalidad simplificó la configuración y redujo la carga operativa al mantener los modelos seguros en su ubicación original.

Para maximizar la eficiencia y reducir los riesgos, se proponen una serie de pasos para establecer el acceso entre cuentas, que incluyen la obtención de permisos entre los roles de IAM necesarios y la configuración de políticas de recursos tanto en los buckets de S3 como en las claves de AWS KMS para garantizar la seguridad de los datos. Estas configuraciones son esenciales no solo para que el equipo de hospedaje pueda tener acceso a los modelos necesarios, sino también para asegurar que cada equipo mantenga su autonomía y controles de seguridad.

A medida que el uso de herramientas como Amazon Bedrock continúa expandiéndose, este enfoque dual de segmentar equipos y optimizar accesos se convierte en un estándar para organizaciones que buscan aprovechar al máximo el potencial de la inteligencia artificial, manteniendo a la vez una alta seguridad y eficiencia operativa.

vía: AWS machine learning blog