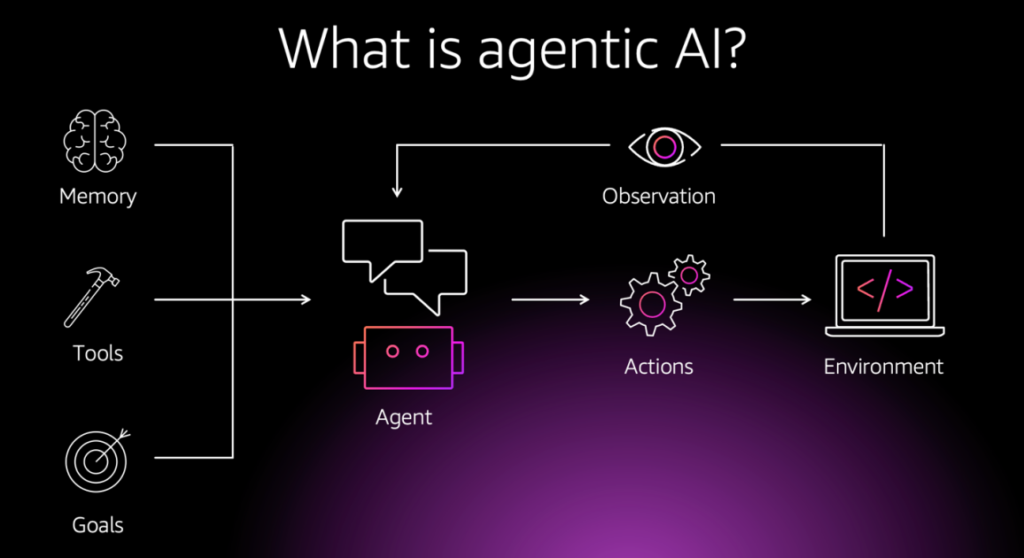

En un panorama tecnológico cada vez más complejo, la confianza en los asistentes de inteligencia artificial (IA) podría ser un error fatal. Recientemente, expertos en ciberseguridad han advertido sobre el peligro de la «contaminación de datos», un fenómeno que puede alterar drásticamente el funcionamiento de los sistemas de IA y, en algunos casos, tener consecuencias potencialmente peligrosas.

La contaminación de datos se refiere a los ataques que buscan modificar el comportamiento de un modelo de inteligencia artificial, resultando en la generación de respuestas incorrectas, sesgadas o incluso dañinas. Dado que la base de funcionamiento de los modelos de IA se sustenta en grandes volúmenes de datos, cualquier alteración en estos conjuntos puede comprometer la integridad del sistema, generando resultados no confiables.

Los ataques de contaminación pueden adoptar varias formas, como la inyección de datos maliciosos que cambian la respuesta de un modelo o ataques internos en los que empleados malintencionados manipulan el conjunto de entrenamiento. También existen técnicas más sofisticadas, como la inyección de desencadenantes, donde se incluyen datos específicos que permiten al atacante manipular la salida del modelo cuando se activa un cierto parámetro.

A medida que estos modelos se integran más en la vida cotidiana, el riesgo de ataques se acentúa. Los sistemas de IA no solo pueden procesar datos internos de empresas, que pueden incluir información sensible, sino que también tienen acceso a datos de usuarios finales, convirtiéndose en blancos atractivos para los cibercriminales.

Para mitigar estos riesgos, se proponen estrategias de prevención que incluyen auditorías continuas de los conjuntos de datos utilizados en el entrenamiento de estos modelos, así como un enfoque proactivo en la ciberseguridad durante su desarrollo. Implementar métodos como la formación adversarial y un modelo de «cero confianza» en la gestión de accesos puede ser crucial para identificar y prevenir accesos no autorizados.

La creación de plataformas de IA seguras desde su diseño no sólo es recomendable, sino esencial. Todos los involucrados en el desarrollo y uso de la inteligencia artificial deben priorizar la integridad de sus sistemas, garantizando que sean resistentes a posibles ataques. A medida que la inteligencia artificial se convierte en una parte integral de nuestras vidas, la seguridad y la confianza en estos sistemas serán más importantes que nunca, requiriendo una colaboración estrecha entre empresas, desarrolladores y reguladores para garantizar que se aproveche su potencial sin poner en riesgo la privacidad y la seguridad de los usuarios.

Fuente: WeLiveSecurity by eSet.