Apple ha tomado una decisión drástica tras una serie de fallos en su tecnología de inteligencia artificial, Apple Intelligence. El sistema, que prometía revolucionar la interacción entre usuarios y dispositivos al generar resúmenes automáticos de noticias y datos, ha sido temporalmente desactivado debido a errores críticos en la generación de información. Este episodio pone en el centro del debate los riesgos asociados al uso de la inteligencia artificial y la necesidad de priorizar la seguridad y precisión en su implementación.

Fallos que pusieron en jaque a la IA de Apple

Los problemas de Apple Intelligence han salido a la luz después de que múltiples usuarios reportaran casos de alucinaciones de IA, un fenómeno en el que el sistema genera información incorrecta o engañosa con apariencia de ser confiable. Entre los ejemplos más alarmantes, se encuentra un mensaje en la app BBC Sport que afirmaba falsamente que el tenista Rafael Nadal había declarado su homosexualidad, confundiendo al deportista con el brasileño João Lucas Reis da Silva. Otro incidente señalaba erróneamente que el primer ministro israelí, Benjamin Netanyahu, había sido arrestado.

Estas notificaciones no solo resultaron inexactas, sino que también pusieron en evidencia la vulnerabilidad de los sistemas automatizados en contextos donde la integridad de la información es crucial. Organizaciones como Reporteros Sin Fronteras alertaron sobre el impacto potencial de estas herramientas en la difusión de noticias falsas, lo que podría socavar la confianza pública en los medios afectados.

La respuesta de Apple: pausa para la IA

En un comunicado oficial, Apple anunció la desactivación temporal de las funciones de generación de noticias automáticas en iOS, iPadOS y macOS. La compañía explicó que están trabajando para mejorar la precisión de su sistema antes de relanzarlo, aunque no proporcionaron una fecha específica para la reactivación de las funciones.

Este movimiento busca limitar el daño reputacional y mitigar los riesgos asociados a la propagación de información incorrecta, algo especialmente relevante en un entorno digital donde las noticias falsas pueden propagarse rápidamente.

Ciberseguridad e IA: un matrimonio complicado

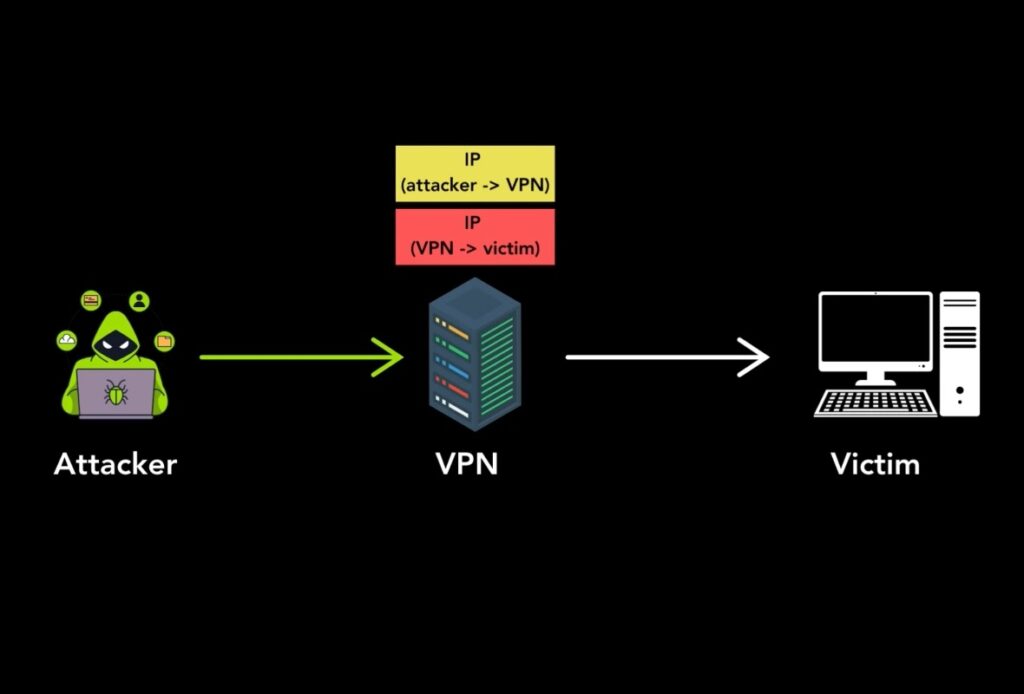

Este caso resalta uno de los mayores desafíos para las empresas que adoptan inteligencia artificial: garantizar que sus sistemas sean confiables y seguros antes de lanzarlos al mercado. Las alucinaciones de IA no solo generan errores técnicos, sino que también representan un riesgo significativo en términos de ciberseguridad.

Un sistema que no valida adecuadamente sus salidas puede ser explotado por actores malintencionados para sembrar desinformación o manipular datos en entornos críticos. La falta de controles estrictos también podría facilitar la introducción de datos manipulados en sistemas que se basan en aprendizaje automático, amplificando el impacto de posibles ataques.

Lecciones aprendidas: cómo mitigar los riesgos

El incidente de Apple Intelligence ofrece importantes lecciones para el sector de la ciberseguridad y las empresas tecnológicas:

- Pruebas rigurosas: Antes de lanzar sistemas de IA al público, es crucial someterlos a ciclos de pruebas exhaustivas que evalúen su precisión y resistencia a errores o manipulación.

- Validación de datos: Implementar mecanismos que verifiquen la exactitud de la información generada antes de enviarla al usuario puede prevenir errores críticos.

- Monitoreo constante: Los sistemas de IA deben ser supervisados de forma continua para detectar y corregir problemas emergentes en tiempo real.

- Transparencia: Informar a los usuarios sobre las limitaciones y riesgos de las tecnologías basadas en IA ayuda a establecer expectativas claras y a mantener la confianza.

Un recordatorio para la industria de la seguridad

El caso de Apple no es único. Varias empresas han enfrentado problemas similares al intentar integrar inteligencia artificial en sus productos sin una validación adecuada. Este incidente debe servir como recordatorio para la industria de la seguridad: la innovación tecnológica no puede comprometer la precisión, la fiabilidad y la ciberseguridad.

En un entorno donde las amenazas digitales evolucionan constantemente, las compañías deben adoptar un enfoque proactivo y ético para desarrollar tecnologías basadas en IA. El equilibrio entre innovación y seguridad será clave para garantizar que estas herramientas cumplan su propósito sin poner en riesgo a los usuarios ni a los sistemas en los que se integran.

vía: Noticias sobre Apple